Подсистемы хранения данных

Технологии подключения к ресурсам в среде совместного доступа

В настоящее время основными применяемыми технологиями являются Fibre Channel и сетевые технологии на основе Ethernet (в основном 100BaseT и Gigabit Ethernet).

Среда Fibre Channel — это логическое развитие стандарта SCSI, более привлекательное для хранения данных. Fibre Channel представляет физический транспортный уровень и набор спецификаций, которые позволяют маршрутизировать и пересылать по оптическим линиям команды SCSI. Можно сказать, что Fibre Channel предоставляет новый уровень возможностей пользователям параллельного SCSI (возможности коммутации, организация петель, большая пропускная способность, большие расстояния).

Перспективы развития технологии Fibre Channel представлены в таблице 1.

Среда на базе Ethernet

Привлекательность Ethernet и его производных заключается в том, что это устоявшийся и широко распространенный стандарт, чего нельзя сказать о Fibre Channel. Отработанные технологии маршрутизации и коммутации позволяют разработчикам эффективно поектировать сети и специально под трафик систем хранения данных, и соединения «островов» хранения данных.

Кроме того, идея использовать единую технологию для огранизации SAN и LAN выглядит довольно привлекательно, так как в этом случае не нужен дополнительный специально обученный персонал для работы с Fibre Channel и не потребуется более дорогое оборудование.

Правда, несмотря на то, что стандарты Ethernet и Gigabit Ethernet уже существуют, процесс приспособления сетевых технологий для хранения и резервного копирования данных только начинается.

Для устройств NAS (подключаемое к сети хранилище данных) некоторые стандарты уже сформировались (Network File System — NFS, Common Internet File System — CIFS).

Сегодня работа над упрощением подключения сетевых систем хранения продолжается. Некоторые сложности вызваны тем, что все архитектуры хранения данных имеют в основе своей блоки команд SCSI. Дисковые и ленточные устройства последние 20 лет работали под прямым управлением блоков команд SCSI, получаемых от операционной системы или приложения.

Fibre Channel можно рассматривать всего лишь как среду передачи SCSI по оптическим линиям. Для протоколов уровня файлов требуется другой подход. Компании-производители (например, Network Appliance) использовали и оптимизировали существующие стандарты (NFS, CIFS), что облегчило доступ к ресурсам хранения данных (дисковые системы) по сетям Ethernet, используя UDP/IP, TCP/IP. До недавнего времени термин Network Attached Storage или Appliance обозначал только дисковую (т. е. первичную) систему хранения данных.

С появлением Gigabit Ethernet ситуация изменилась. В некоторых реализациях компоненты Gigabit Ethernet могут работать с существующими кабельными сетями (cat5 или лучше). В настоящее время уже ожидается начало поставок 10 Gigabit Ethernet.

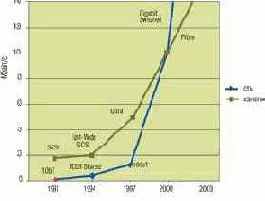

На рис. 2 представлена величина пропускной способности для сетей и для подключаемых устройств. Можно заметить, что в течение многих лет развитие сетевых технологий не приводило к значительному росту пропускной способности. Коммутируемая среда Gigabit Ethernet определила экспоненциальный рост пропускной способности сетей.

Сетевые технологии применительно к хранению и резервному копированию имеют свои достоинства и недостатки.

Достоинства

• Обслуживающий персонал уже знаком с основными технологиями.

• Возможность проектировать сети с заданным трафиком. Использование подсетей, технологий коммутации и маршрутизации позволяет достаточно комфортно наращивать сеть по мере необходимости.

• Устойчивые, отработанные драйверы, устойчивость к сбоям и распространенность. Драйверы пишутся и встраиваются в приложения и операционные системы уже много лет. Все основные операционные системы имеют поддержку TCP/IP. В основу SCSI (соответственно и Fibre Channel) заложен постулат гарантированных коммуникаций (т. е. то, что было отправлено, будет получено адресатом).

В основе TCP/IP, наоборот, заложена устойчивость к сбоям в канале передачи (повторная отправка, перемаршрутизация в случае неблагоприятных условий).

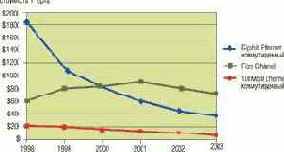

• Высокая эффективность вложенных средств. Благодаря большим объемам потребления сетевого оборудования и конкуренции между изготовителями стоимость сетевой инфраструктуры сильно уменьшилась и продолжает сокращаться. На рис. 3 приведены изменения стоимости сетей в пересчете на один порт.

Недостатки

Сетевые приложения, особенно приложения, работающие с лентами, требуют передачи по сети больших блоков данных. Сетевые технологии, основанные на TCP/IP, требуют обработки стеков TCP на обоих концах тракта передачи данных. Обработка стека в свою очередь является довольно ресурсоемкой задачей и может существенно снизить производительность всей системы. Все изготовители лихорадочно работают над созданием аппаратных ускорителей (которые могли бы снять с CPU функции обработки стека TCP) или над созданием более быстрых процессоров.

Если для Gigabit Ethernet эти трудности так или иначе удалось преодолеть, то с выходом на рынок технологии 10 Gigabit Ethernet достигнутый уровень снова станет «нулевой отметкой».

Стандартов для подключения ленточных устройств к сети до недавнего времени не существовало. А в отсутствии стандартов изготовители ленточных NAS-устройств сталкиваются со следующими трудностями:

• Недостаток сетевых стандартов для ленточных устройств. Существующие стандарты для дисковых устройств для лент непригодны для лент. Сейчас формируются новые стандарты именно для ленточных устройств и, скорее всего, через некоторое время установится несколько стандартов.

• Недостаточная гибкость приложений. Приложения резервного копирования в основном рассчитаны на работу с обычными подключенными к серверам SCSI-приводами магнитных лент и роботизированными механизмами. Поэтому приложение при работе полностью захватывает ленточные ресурсы. Для того чтобы те же приложения могли работать в новой среде, требуется добавление специальных программных модулей.

Эти опции для организации совместного доступа к устройствам первоначально были сделаны для сетей хранения данных (SAN) на базе Fibre Channel.

• Ленточные ресурсы требуют подключения на уровне блоков данных. Стандарты подключения на уровне файлов, которые хороши для дисковых систем (NFS, CIFS), в данном случае не годятся.

• Важность уровня производительности. В отличие от дисковых систем, приложения, работающие с лентами, требуют несколько большей пропускной способности и поддержания постоянного потока данных. Только в этом случае ленточное устройство будет работать с максимальной эффективностью. Это стало возможным только с появлением Gigabit Ethernet и технологии коммутации. Другая сложность состоит в том, что обработка стеков TCP/IP требует много процессорных ресурсов. Это решается при помощи более быстрых процессоров и сетевых карт с аппаратной обработкой стеков.

• Размер пакетов. Для приложений, работающих с лентами, увеличение блоков данных, передаваемых по шине SCSI, ведет к существенному повышению производительности системы. Для устройств с произвольным доступом это совсем не так, потому что данные на дисках заведомо имеют фрагментарную структуру. Большинство операций с дисками заканчивается чтением или записью небольших объемов данных. Для лент, наоборот, как правило, передаются мегабайты или гигабайты данных. Поэтому увеличение размера блока или пакета данных позволит увеличить пропускную способность за счет уменьшения дополнительной нагрузки. В технологиях TCP/IP используются пакеты с переменной длиной от 60 до 1518 байт. Для сетей хранения данных предложен новый стандарт, Jumbo Frames, где размер сетевого пакета составляет примерно 9000 байт.

Для того чтобы в полной мере пользоваться преимуществами совместного доступа к ленточным устройствам, изготовителям нужно преодолеть указанные выше трудности. Необходимые для этого технологии доступны уже сегодня.

Для организации совместного доступа к ресурсам хранения/резервного копирования по IP-сетям в настоящее время существует несколько протоколов.

Это протокол, ориентированный на хранение данных и предназначенный для подключения SCSI-устройств при помощи сетей TCP/IP. На рис. 4 показано, как работает среда iSCSI.

Аналогично протоколу ITP, в среде iSCSI используется виртуальный адаптер, который принимает команды SCSI от операционной системы и транслирует их в маршрутизируемые сетевые пакеты. Переданная по сети команда на приемной стороне реассемблируется и передается на SCSI-устройство.

ITP

Протокол предложен компанией Spectra Logic специально для обеспечения работы приводов магнитных лент, автозагрузчиков и библиотек с существующими приложениями и операционными системами, пока спецификация iSCSI

не будет окончательно ратифицирована. Так же, как и в случае iSCSI, команды SCSI инкапсулируются в серию небольших сетевых пакетов и маршрутизируются на соответствующее устройство, подключенное к сети. ITP использует технологию TCP/IP, что позволяет гарантировать доставку пакетов по назначению. ITP работает аналогично iSCSI, за исключением некоторых дополнений, улучшаюших безопасность и интероперабельность между существующими устройствами, операционными системами и приложениями резервного копирования. Пользователи ITP легко смогут перейти на iSCSI, как только этот стандарт будет ратифицирован и появятся соответствующие программные драйверы устройств.

iFCP

Это протокол-шлюз, предназначенный для подключения построенных на Fibre Channel сетей хранения данных (SAN) и устройств SCSI. FCP представляет собой протокол Fibre Channel для SCSI. Он картирует команды SCSI и связанные с ними данные на транспортный уровень Fibre Channel FC-2. iFCP картирует существующий стандарт FCP и связанные с ним службы Fibre Channel на TCP/IP. Можно использовать даже при ненадежной работе основной сети IP.

Основное преимущество iFCP как протокола — вход в SAN заключается в картировании FCP на TCP, делая возможным сетевые (а не «точка-точка») соединения между сетями хранения. Таким образом, iFCP предлагает альтернативу для туннелирования фреймов Fibre Channel в TCP/IP.

Для существующих драйверов и контроллеров FCP протокол iFCP предоставляет надежную транспортную среду между доменами SAN, и при этом никаких модификаций существующих продуктов не требуется.

Так как xFCP используют уровень FC layer 4, то можно ожидать интероперабельности с огромным числом существующих сегодня на рынке устройств и приложений SAN. Эта стратегия предоставляет возможность миграции от сегодняшней продукции к завтрашним сетям хранения данных, основанных на IP.

mFCP (Metro FCP) — сетевой протокол для хранения данных, интероперабельный с iFCP. Это протокол для глобальных и локальных сетей хранения данных, который позволяет устройствам хранения FCP применять для сетевых подключений UDP/IP и Gigabit Ethernet. Протокол mFCP представляет прямую альтернативу транспортному механизму Fibre Channel. Существующие драйверы и контроллеры FCP можно использовать без всяких модификаций. iFCP предназначен для работы в высоконадежных сетях с малой задержкой. За счет того, что тактовая частота у Gigabit Ethernet выше, чем у Fibre Channel, можно получить и большую пропускную способность.

NDMP — Network Data Management Protocol, сетевой протокол управления данными. Это протокол, базирующийся на открытых стандартах, предназначенный для выполнения резервного копирования сетевых устройств хранения данных в гетерогенной среде на больших предприятиях. Разработан совместно Network Appliance и IntelliGuard Software.

Архитектура состоит из клиент-серверной модели, где приложение резервного копирования является клиентом NDMP-сервера. Сервер NDMP имеет две функции:

1. Сервер данных — служба читает данные с диска и формирует в специальном формате поток данных NDMP или читает поток NDMP и записывает его на диск, в зависимости от того, какая операция (резервное копирование или восстановление данных) выполняется.

2. Сервер лент — служба считывает поток NDMP и записывает его на ленту или считывает данные с ленты и формирует поток NDMP, в зависимости от выполняемой операции.

Jumbo Frames. С появлением Gigabit Ethernet, увеличением сетевого трафика, инициатив использования IP для целей хранения данных обычная упаковка данных в небольшие сетевые пакеты стала препятствием для достижения максимальной производительности сетей, серверов и устройств хранения данных. Увеличение размера фрейма с 1518 до 9000 байт — совершенно логичный шаг к увеличению производительности. Увеличенные и стандартные пакеты прозрачны друг для друга, поэтому они вполне могут сосуществовать в одной сети. Применение Jumbo Frames позволяет с одной стороны увеличить пропускную способность на 50%, а с другой стороны, уменьшить на 50% загрузку центрального процессора.

Есть и другие протоколы, связанные с сетевым хранением данных. Это SNMP — Simple Network Management Protocol. Протокол создан как интероперабельный инструмент управления большой сетью с оборудованием от разных производителей. Также есть HTTP/FTP. Данный протокол схож с SNMP, используется для доступа к устройствам через веб с целью конфигурации и апгрейда внутреннего программного обеспечения.

В рамках одной статьи невозможно разобрать все существующие протоколы, определить их достоинства и недостатки. Но этого и не требуется. К тому же само разнообразие говорит о том, что единого на все случаи решения нет и пока не предвидится.

Что же делать системному администратору, когда для обеспечения оптимальной работы системы резервного копирования данных в корпоративной сети нужно пользоваться несколькими протоколами?

Самый простой и дорогой способ — поставить несколько специализированных библиотек магнитных лент и по мере необходимости продолжать этот процесс.

Более интересное решение — концепция специализированной операционной системы для магнитных лент, предложенная компанией Spectra Logic. Фирменное название TAOS (Tape Appliance Operation System).

Эта архитектура предлагает подход, который, с одной стороны, базируется на существующих стандартах, а с другой — не зависит от конкретного протокола. В нем поддержаны все существующие для ленточных систем сетевые стандарты.

Кроме того, по мере возникновения могут легко добавляться новые протоколы. Первоначально TAOS служил связью между сетями Fibre Channel и устройствами SCSI. Сейчас же фокус сместился в сторону Ethernet и IP.

Преимущества такого подхода особенно хорошо видны на фоне современных тенденций к изменению архитектур хранения данных и связанных с ними протоколов. TAOS-устройства будут поддерживать все основные стандарты хранения данных. Включенное в сеть Ethernet такое устройство само определит присутствующие компоненты (сетевые платы, адаптеры, контроллеры дисков или лент и т. д.), к которым произведено подсоединение, и выберет способ коммуникаций. Если окажется, что устройство включено не в среду TAOS, то взаимодействие произойдет согласно используемому в сети протоколу (iSCSI, iFCP и т. д.). Когда же устройство подключено к среде TAOS, взаимодействие устройств будет гораздо эффективнее, так как архитектура TAOS более оптимизирована для работы с ленточными системами, чем любой из стандартных протоколов.

Для того чтобы начать пользоваться архитектурой TAOS, требуется наличие виртуального адаптера и ленточного устройства с контроллером TAOS, причем это может быть как недорогой автономный привод магнитных лент, так и большая корпоративная библиотека магнитных лент.

Работа арихитектуры TAOS видна из рис. 5. Подразумевается выполнение стандартной операции резервного копирования или восстановления. В качестве приложения может быть стандартное приложение резервного копирования (NetBackup от Veritas, NetWorker от Legato, ARCServe от Computer Associate). Оборудование резервного копирования включает в себя библиотеку магнитных лент с роботизированной системой, приводом (приводами) магнитных лент SCSI.

Приложение инициирует процесс резервного копирования. Вначале процесса приложение транслирует запрос данных в команды операционной системы. Для среды с интерфейсом SCSI операционная система транслирует эти команды в команды SCSI и передает их на уровень драйвера устройств.

Это виртуальный адаптер, или драйвер TAOS, который встраивается в операционную систему и воспринимается ОС как обычный контроллер SCSI.

После «пакетизирования» команд SCSI виртуальный адаптер запускает стандартные службы TCP/IP, или «стек» (для Windows NT это Winsock32). Стек TCP/IP операционной системы направляет пакеты на сетевую карту для дальнейшего маршрутизирования на устройство назначения.

Драйвер устройств TAOS выполняет две задачи. Для маршрутизации SCSI по IP драйвер должен быть сконфигурирован так, чтобы указывать на IP-адрес контроллера (контроллеров) TAOS, стоящих в ленточных устройствах/библиотеках. Вторая функция заключается в соответствующей трансляции протокола. Уровень трансляции протокола может быть сконфигурирован для работы с любым из протоколов хранения данных (iSCSI, ITP и т. д.).

По завершении обработки стека и протокола, контроллер передает команды SCSI на устройство (роботизированная система или привод магнитных лент). Архитектура контроллера такова, что преобразование возможно как на SCSI, так и на Fibre Channel или каком-нибудь новом стандарте, который появится в будущем.

Далее, SCSI устройство обычно передает обратно статус. Весь процесс передачи команды SCSI через IP происходит в обратном направлении. Как только операционная система или приложение получают статус от устройства, может быть запущена следующая команда из последовательности резервного копирования.

Архитектура TAOS обладает следующими преимуществами:

• Независимость от протокола. По мере появления, можно добавлять новые протоколы.

• Совместимость с современными приложениями для управления хранением данных. Несколько виртуальных контроллеров (драйверов TAOS) могут пользоваться одним и тем же физическим ленточным устройством.

• Поддержка всех распространенных операционных систем. В настоящее время есть поддержка для Windows NT, 2000, Sun Solaris, Linux. Существует поддержка работы с NAS устройствами Network Appliance. Работы по поддержке остальных операционных систем в настоящее время продолжаются.

• Поддержка автономных приводов магнитных лент и библиотек. TAOS предоставляет прозрачное подключение для любых автозагрузчиков SCSI, Fibre Channel, оборудованных приводами Sony AIT или DDS, Exabyte VXA, Mammoth, Quantum/Tandberg DLT1, DLT, SDLT, DDS, LTO от Seagate, HP.

• Доступность решений начального уровня. Благодаря невысокой стоимости архитектура TAOS может быть использована и для подключения недорогих автономных приводов магнитных лент.

• Доступность решений класса High-End. С целью полного обеспечения потребностей рынка корпоративных систем есть план развития архитектуры TAOS, где учитываются повышенные требования к производительности, устойчивости к сбоям, функциональности. Этот подход реализован в фирменной архитектуре библиотек магнитных лент Gator, где используется несколько контроллеров TAOS, называемых Quad Interface Controller.

И в завершении обзора архитектуры TAOS несколько слов о логической организации одноименного контроллера.

Физический уровень межсоединений. Назначение в форматировании и передаче данных на подключенные устройства. Каждый контроллер имеет часть для подключения к хосту системы (в настоящее время есть Fibre Channel, 10/100BaseT, Gigabit Ethernet). Для Ethernet-устройств уровень межсоединений имеет сетевые службы MAC и TCP/IP.

Со стороны SCSI обеспечивается подключение к приводам магнитных лент и роботизированным системам.

«Движок» передачи данных.

Используется высокоскоростной «движок» DMA, состоящий из буферной памяти и микропроцессорной архитектуры.

На этом обзор теоретической части можно закончить и перейти к практическому разделу.

В качестве примера реализации системы резервного копирования разберем задачу, где требуется в течение одного часа записать на ленту 1 Tбайт данных.

Эта задача была решена командой специалистов из Network Appliance, Spectra Logic и Veritas в Технологическом центре в г. Колорадо-Спрингс (США), в феврале 2002 года.

Использованное оборудование:

• Библиотека магнитных лент: Spectra 64000 c 16 приводами Sony AIT-3.

• Дисковая подсистема: четыре устройства хранения данных NetApp F880 с двумя полками по 14 дисков каждая, всего 28 дисков по 72 Гбайт, каждое устройство имеет два порта Fibre Channel.

• ПО резервного копирования: Veritas NetBackup Data Center 4.5 с опцией NDMP.

• Подключения: двойная сеть SAN, в которой использовано для коммутатора Brocade 2400 Silkworm. Использованы «медные» кабели.

• Диски и расположение файлов: каждое NAS-устройство имеет два тома по 14 дисков, объединенных в RAID, каждый том состоит из двух Q-деревьев по 64 Гбайт.

• Сервер резервного копирования: два сервера, каждый из которых имеет процессор Pentium III 400 и ОС Windows 2000 Professional.

Решение должно обладать быстрым доступом к дискам и быть масштабируемым, не должно предъявлять серьезных требований к серверам.

Отправной точкой была скорость проводных соединений.

Выбран стандартный 1- Гбайт канал Fibre Channel. Теоретически для того, чтобы передать 1 Tбайт данных за час, требуется пропускная способность канала 285 Mбайт/с. На самом деле необходима большая скорость для компенсации задержек, времени, затрачиваемого на позиционирование и другие операции с носителями. Исходя из этого, было определено, что для получения нужной скорости передачи требуется четыре канала Fibre Channel.

Выбор компонентов

Были рассмотрены разные архитектуры дискового хранения данных. Выбрана архитектура NAS, так как она позволяет снизить нагрузку на сервер резервного копирования.

NAS от Network Appliance с NDMP позволяет проводить резервное копирование непосредственно по Fibre Channel на ленточную систему, минуя сервер. Были выбраны 4 устройства Network Appliance F880, которые и образовали 4 независимых канала Fibre Channel.

Библиотека Spectra 64000 имеет интегрированный Fibre Channel, при этом внешних мостов FC-SCSI не требуется.

Для управления резервным копированием был выбран Veritas NetBackup DataCenter 4.5 с опцией NDMP.

Организация дискового хранилища

Резервное копирование большого количества данных за небольшой период времени требует от дисковой системы высокой производительности. Система должна одновременно выполнять несколько операций чтения без замедления выполнения каждой операции. Самым лучшим подходом является организация RAID из достаточно большого числа дисков, чтобы у каждого диска было достаточно времени для позиционирования и чтения данных без прерывания потока данных для резервного копирования. Для организации работы приложений типа реляционных баз данных тоже требуется параллельное выполнение большого количества операций чтения.

В нашем случае: для резервного копирования 1 Tбайт данных было создано 16 деревьев директорий по 64 Гбайт каждая.

Эта структура распределена по четырем NAS-устройствам. Таким образом, на каждом из них размещается по четыре дерева директорий. Каждый NAS-сервер состоит из двух томов RAID, каждый том, в свою очередь, состоит из 14 дисков (включая один диск с четностью). Один том RAID из 14 дисков позволяет поддерживать параллельно два потока данных с достаточной скоростью.

В каждом томе создано по два Q-дерева, чтобы разделить два дерева директорий в каждом томе. Применение Q-деревьев также позволяет ПО резервного копирования эффективно разделять потоки данных, что увеличивает общую производительность за счет резервного копирования поддиректорий.

Построение масштабируемого решения

Для достижения скорости 80 Mбайт/с с одного NAS-устройства происходит резервное копирование на четыре привода магнитных лент AIT-3. В результате тестирования было также определено, что для получения нужной пропускной способности каждое NAS-устройство должно иметь два канала Fibre Channel. В результате добавления второго канала Fibre Channel появился некоторый запас по производительности и надежности. Второй порт Fibre Channel должен быть подключен к отдельному коммутатору. Таким образом были определены дополнительные пути доступа к магнитным лентам, что является одной из стратегий достижения высокой готовности.

Соединение всех компонентов

Для подключения устройств NAS к библиотеке магнитных лент по Fibre Channel была построена сеть хранения данных. Каждое NAS-устройство имеет два порта Fibre Channel, подключаемых к своему коммутатору Brocade. К каждому коммутатору подключено четыре интерфейсных модуля F-QIP библиотеки Spectra 64000. Процесс резервного копирования контролируют серверы Windows 2000, подключенные к Ethernet.

На одном сервере установлен NetBackup DataCenter 4.5, и этот сервер является мастер-сервером. На втором сервере установлен NetBackup DataCenter 4.5 media server.

Для проведения резервного копирования/восстановления данных с NAS-устройств была установлена опция NetBackup for NDMP.

Протокол NDMP предоставил необходимый контроль процесса резервного копирования, выполняемого на NAS-устройствах. Сервер выполняет приложение резервного копирования NDMP, от начала до конца по сети, в то время как данные, записываемые на ленту, идут по другому пути, которым в данном случае является Fibre Channel. Каджое NAS-устройство, подключенное к сети хранения данных, имеет доступ к 16 подключенным к Fibre Channel приводам магнитных лент.

ПО NetBackup отслеживает, какие задания передаются на какой привод. Также контролируется расписание начала выполнения заданий. После выполнения резервного копирования ПО каталогизирует, какие файлы были скопированы, когда и в какой области носителя хранятся.